필터 버블

"오늘의AI위키"의 AI를 통해 더욱 풍부하고 폭넓은 지식 경험을 누리세요.

1. 개요

필터 버블은 구글, 아마존, 페이스북 등 인터넷 정보 제공자가 이용자의 성향에 맞춰 정보를 필터링하여, 이용자가 제한된 정보만 접하게 되는 현상을 의미한다. 이 개념은 엘리 패리저의 저서 《생각 조종자들》에서 처음 등장했으며, 인터넷 기업들은 사용자의 검색 기록, 관심사 등을 수집하여 알고리즘을 통해 맞춤형 정보를 제공한다. 필터 버블은 확증 편향을 심화시키고, 가치관 왜곡, 사회적 양극화를 초래하며, 민주주의를 위협할 수 있다는 비판을 받는다. 사이버 발칸화 현상을 악화시킨다는 지적도 있으며, 이에 대응하기 위해 개인은 다양한 정보를 접하고, 미디어 기업은 알고리즘 개선 노력을 기울이고 있다.

더 읽어볼만한 페이지

- 대중 매체의 영향 - 미디어 문화

- 대중 매체의 영향 - 주류 미디어

주류 미디어는 영화, 텔레비전, 신문, 라디오 등 전통적인 매체를 지칭하며, 미디어 소유권 집중과 디지털 플랫폼 부상으로 변화를 겪고 있으며, 젊은 세대는 디지털 플랫폼을 통해 정보를 얻는 경향이 강해지고 있다. - 매체 편향 - 언론의 객관성

언론의 객관성은 진실성과 중립성을 바탕으로 기자들이 어느 한쪽으로 치우치지 않고 정확하고 공정하게 사실만을 보도해야 한다는 저널리즘의 원칙이지만, 여러 요인으로 인해 비판을 받으며 그 실현 가능성과 한계에 대한 논의가 지속적으로 이루어지고 있다. - 매체 편향 - 선전 모델

선전 모델은 미디어가 권력 구조의 영향으로 특정 메시지를 전달하고 여론을 조작하는 방식을 설명하는 이론으로, 다섯 가지 필터를 통해 미디어 콘텐츠가 기업 이익을 선호하는 방향으로 편향된다고 주장하지만, 미디어의 다양성과 기업 부패 보도 사례 등 비판도 존재한다. - 역정보 - 정보전

정보전은 정보 우위를 확보하기 위해 평시와 전시를 가리지 않고 수행하는 활동으로, 상대방의 정보 체계를 교란하거나 아군의 정보 체계를 보호하는 것을 목표로 하며, 정보통신기술 발달과 함께 그 중요성이 커지고 국가 안보의 핵심 과제로 대두되고 있다. - 역정보 - 대중조작

대중조작은 물리적 힘 없이 군중의 참여, 통제, 영향력 행사를 통해 특정 목표를 달성하는 행위로, 선전, 권위, 장소 선정, 전달 방식 등 다양한 요소를 활용하여 정치, 종교, 소셜 미디어 등 여러 분야에서 사용되며 민주주의 사회에서는 여론 조작의 위험성과 윤리적 문제가 논의된다.

2. 개념

구글, 아마존, 페이스북 등 인터넷 정보제공자가 이용자에 맞추어 필터링한 정보를 제공하여, 이용자가 이미 필터링된 정보만을 접하게 되는 현상을 말한다. 같은 단어를 검색해도 이용자에 따라 다른 정보가 화면에 나타난다.

이 용어는 미국의 정치 참여 시민단체 무브온의 이사장인 엘리 패리저(Eli Pariser)의 저서 《생각 조종자들(원제: The Filter Bubble)》에서 등장했다. 인터넷 정보제공자들은 이용자의 개인적 성향, 관심사, 사용 패턴, 검색 기록 등의 데이터를 수집하여 각 기업의 알고리즘을 통해 분석하고, 이에 따라 우선적으로 노출시킬 정보를 선별한다. 페이스북, 구글, 왓챠, 야후 등이 이러한 방식으로 선별적인 정보를 제공한다.

파리저는 필터 버블을 "알고리즘에 의해 제공되는 개인적인 정보 생태계"라고 정의했다.[8] 그는 2011년 5월 TED 강연에서 필터 버블의 작동 방식과 볼 수 있는 곳에 대한 예시를 제시하며 이 개념을 널리 알렸다.

필터 버블은 "스플린터넷"(splinternet) 또는 "사이버 발칸화"(cyberbalkanization)라고 불리는 현상을 악화시키는 것으로 묘사된다.[28] 이는 인터넷이 서로 비슷한 생각을 가진 사람들의 하위 그룹으로 나뉘어 자체 온라인 커뮤니티 내에서 고립되고 다른 견해에 노출되지 않는 현상을 말한다. "사이버 발칸화"라는 용어는 1996년에 만들어졌으며,[29][30][31] "이데올로기적 프레임"(ideological frames),[9] "인터넷을 검색할 때 주변을 둘러싼 비유적인 영역"[18]과 같은 표현으로도 설명된다.

필터 버블 개념은 정치적 견해뿐만 아니라 경제적, 사회적, 문화적 상황에 따라 스스로 분리되는 사회를 묘사하는 데에도 사용된다.[32] 버락 오바마는 버락 오바마의 고별 연설에서 필터 버블과 유사한 개념을 "미국 민주주의에 대한 위협"으로 규정하기도 했다.[33]

필터 버블은 모든 방향에서 자신과 같은 의견이 돌아오는 폐쇄된 공간에 있게 된 결과, 다양한 사람들의 의견을 듣고 다양한 생각을 알 수 없게 되며, 자신의 의견만이 증폭·강화되는 "에코 체임버 현상"과도 관련이 깊다.

2. 1. 작동 방식

구글, 아마존, 페이스북 등의 인터넷 정보제공자가 이용자에 맞추어 필터링한 정보를 이용자에게 제공함으로써, 이용자가 이미 필터링된 정보만을 접하게 되는 현상이다. 같은 단어를 검색하여도 이용자에 따라 다른 정보가 화면에 나타난다.이 용어는 미국의 정치 참여 시민단체 '무브온'의 이사장인 엘리 패리저(Eli Pariser)의 저서 《생각 조종자들(원제 The Filter Bubble)》에서 등장하였다. 인터넷 정보제공자들은 이용자의 개인적 성향, 관심사, 사용 패턴, 검색 기록 등의 데이터를 수집하여 각 기업의 알고리즘을 통해 분석하고, 이에 따라 우선적으로 노출시킬 정보를 선별한다. 페이스북, 구글, 왓챠, 야후 등이 이러한 방식으로 선별적인 정보를 제공한다.

파리저는 필터 버블을 "알고리즘에 의해 제공되는 개인적인 정보 생태계"라고 정의했다.[8] 인터넷 사용자의 과거 검색 및 탐색 기록은 사용자가 링크 클릭, 친구 보기, 영화 대기열에 추가, 뉴스 기사 읽기 등을 통해 특정 주제에 관심을 보일 때 축적된다.[18] 그러면 인터넷 기업은 이 정보를 사용하여 사용자에게 맞춤형 광고를 제공하거나 특정 유형의 정보가 검색 결과에 더 두드러지게 나타나도록 한다.[18]

파리저에 따르면 이 과정은 세 단계로 이루어진다. 먼저 사람들이 누구이고 무엇을 좋아하는지 알아낸다. 그런 다음 그들에게 가장 적합한 콘텐츠와 서비스를 제공한다. 마지막으로 적합성을 정확하게 조정한다. 즉, 개인의 정체성이 미디어를 형성하는 것이다.[19]

사이트 트래픽 측정을 통해 표시되는 링크 클릭 데이터에 접근하면 필터 버블이 집단적이거나 개별적일 수 있음을 알 수 있다.[21]

2011년 당시 한 엔지니어는 파리저에게 Google이 사용 중인 컴퓨터의 종류와 사용자의 물리적 위치와 같은 쿠키가 아닌 데이터를 포함하여 사용자의 검색 결과를 개인적으로 맞춤화하기 위해 57개의 서로 다른 데이터를 살펴본다고 말했다.[22]

파리저의 필터 버블 개념은 2011년 5월 TED 강연 이후 유명해졌다. 그는 강연에서 필터 버블의 작동 방식과 볼 수 있는 곳에 대한 예시를 제시했다. 필터 버블 효과를 보여주기 위한 테스트에서 파리저는 여러 친구들에게 Google에서 "이집트"라는 단어를 검색하고 결과를 보내달라고 요청했다. 두 친구의 첫 페이지 결과를 비교했을 때 뉴스나 여행과 같은 주제에 대한 중복은 있었지만, 한 친구의 결과에는 당시 진행 중이던 2011년 이집트 혁명에 대한 정보 링크가 두드러지게 포함되어 있었던 반면, 다른 친구의 첫 페이지 결과에는 그러한 링크가 없었다.[23]

인터넷 검색 사이트는 각 사용자를 식별하는 메커니즘(쿠키, 핑거프린팅 등)을 사용하여 각 사용자의 위치, 과거 클릭 기록, 검색 기록 등과 같은 개인 정보를 파악한다.[109] 그리고 각 사용자의 개인 정보를 각 검색 사이트의 알고리즘에 따라 분석하여 해당 사용자가 보고 싶어할 정보를 선택적으로 추정하고, 사용자가 보고 싶어하지 않을 정보는 차단한다.[110] 그 결과 각 사용자에게 최적화된, 각 사용자가 보고 싶어할 검색 결과만을 반환한다.[111] Google이나 Facebook 등 대부분의 웹사이트에서 표준으로 도입되어 있으며, 같은 "인터넷"을 보고 있다고 생각해도 사람들이 실제로 보고 있는 것은 이처럼 "필터"를 통해 개인화된 세계이다.[112]

원하는 검색 결과가 나오는 알고리즘을 가진 웹사이트일수록 사용자에게 좋은 웹사이트로 평가되므로 각 사이트의 검색 알고리즘은 더욱 발전한다. 하지만 검색 사이트의 알고리즘이 더욱 발전하고 원하는 검색 결과가 나오게 되면, 궁극적으로는 자신이 보고 싶은 정보[113] 이외의 것을 인터넷에서 볼 수 없게 된다. 그리고 자신의 관점과 맞지 않는 정보로부터 고립되어 같은 의견을 가진 사람들끼리 무리를 이루게 되고, 각 집단마다 문화적, 사상적 막(버블) 속에 고립되어 간다. 이러한 현상을 "필터 버블"이라고 한다.

이 용어는 인터넷 환경 운동가인 일라이 패리서가 2011년에 출판한 같은 제목의 저서 『The Filter Bubble』(한국어 번역본은 『닫힌 인터넷』이라는 제목으로 2012년에 출간)에서 만들었다. 이 책에 따르면, 사용자는 점차 자신의 생각과 대립되는 관점의 정보에 접할 수 없게 되고, 자신의 정보 막 속에서 지적 고립에 빠진다. 일라이 패리서는 2016년에 "『좋아요!』를 누른 사람들의 글만 보고 있다 보니, 당신이 극도로 싫어하는 사람이 대통령[114]이 되어 있는 것을 보고 놀라게 될 거예요"라고 말했다.[115]

파리서는 필터 버블 개념을 “(검색 엔진의) 알고리즘에 의해 초래되는 정보의 개인적 생태계”로 정의한다.[116] 같은 현상을 나타내는 데 “이데올로기적 틀(ideological frame)”[117] 또는 “인터넷 검색 시 당신을 감싸고 있는 비유적인 구체”[118] 와 같은 다른 표현이 사용되기도 했다.

인터넷 이용자가 “링크를 클릭하고, 친구를 방문하고, 동영상을 재생 대기열에 추가하고, 뉴스를 읽는다” 등 특정 주제에 관심을 보이면 과거 검색 기록이 축적된다.[118] 그러면 인터넷 사업자는 이러한 정보를 이용하여 해당 사용자를 대상으로 광고를 게재하거나 검색 결과가 더욱 눈에 띄도록 한다.[118]

2. 2. 에코 체임버와의 비교

"메아리 방"과 "필터 버블"은 개인이 자신의 기존 신념과 편향을 강화하는 좁은 범위의 의견과 관점에 노출되는 상황을 설명하지만, 특히 소셜 미디어와 관련된 관행에서는 두 가지 개념 사이에 미묘한 차이가 있다.[34][35]뉴스 미디어와 관련하여 메아리 방은 폐쇄 시스템 내에서 의사소통과 반복을 통해 신념이 증폭되거나 강화되는 상황을 은유적으로 설명하는 표현이다.[36][37] 선택적 노출 이론을 바탕으로, 이 용어는 소리가 빈 공간에서 반향하는 음향 메아리 방을 기반으로 한 은유이다. 소셜 미디어와 관련하여 이러한 상황은 사용자가 다른 사용자를 팔로우하거나 그룹을 선택하는 기능과 같이 특정 플랫폼의 사용자가 정보 소비를 적극적으로 선택할 수 있는 모든 과정을 설명하는 ''자기 선택적 개인화''의 명시적 메커니즘으로 이어진다.[38]

메아리 방에서는 사람들이 자신의 기존 견해를 강화하는 정보를 찾을 수 있으며, 무의식적인 확증 편향 행위일 수 있다. 이러한 피드백 조절은 정치적 및 사회적 양극화와 극단주의를 증가시킬 수 있다. 이는 사용자가 소셜 네트워크 내에서 동질적인 클러스터로 집합하게 하여 집단 극단화에 기여할 수 있다.[39] "메아리 방"은 사실적 근거 없이 개인의 신념을 강화한다. 개인은 동일한 관점을 인정하고 따르는 사람들로 둘러싸여 있지만, 메아리 방 밖으로 나갈 수 있는 능력도 가지고 있다.[40]

반면, 필터 버블은 사용자의 미디어 소비가 개인화된 알고리즘에 의해 생성되는 ''사전 선택적 개인화''의 암시적 메커니즘이다. 사용자가 보는 콘텐츠는 기존의 신념과 선호도를 강화하는 AI 기반 알고리즘을 통해 필터링되며, 반대되는 관점이나 다양한 관점을 배제할 수 있다. 이 경우 사용자는 더 수동적인 역할을 하고, 자신의 세계관에 도전하는 정보에 대한 노출을 자동으로 제한하는 기술의 피해자로 인식된다.[38] 그러나 일부 연구자들은 사용자가 여전히 검색 엔진과 소셜 미디어 네트워크와의 상호 작용을 통해 자신의 뉴스피드와 정보 출처를 선택적으로 큐레이팅하는 적극적인 역할을 하기 때문에 AI 기반 알고리즘에 의한 필터링 과정을 직접 지원하여 사실상 자기 분리 필터 버블에 참여한다고 주장한다.[41]

차이점에도 불구하고, 이러한 용어의 사용은 학문적 연구와 플랫폼 연구 모두에서 밀접하게 관련되어 있다. 필터링 알고리즘에 대한 접근성의 제한으로 인해 소셜 네트워크 연구에서 두 가지 개념을 구분하기 어려운 경우가 많으며, 이는 두 개념의 능동성을 비교 및 대조할 수 있도록 할 수 있다.[42]

"에코 체임버"에 있는 것처럼, 모든 방향에서 자신과 같은 의견이 돌아오는 폐쇄된 공간에 있게 된 결과, 다양한 사람들의 의견을 듣고 다양한 생각을 알게 되는 것이 아니라, 단순히 자신의 의견이 증폭·강화될 뿐인 "에코 체임버 현상" 등과도 관련이 깊은 용어이다.

3. 비판과 우려

"필터 버블"은 인터넷 사용자가 자신의 관심사에 맞는 정보만 접하게 되어, 편향된 시각을 가질 수 있다는 개념이다. 이는 엘리 패리저가 그의 저서 《생각 조종자들》에서 처음 제시한 용어로, 알고리즘에 의한 정보 필터링이 개인에게 미치는 영향에 대한 우려를 담고 있다.[138]

패리저는 2011년 TED 강연에서 필터 버블의 위험성을 경고했다. 그는 자신의 페이스북 '피드'에 보수 성향의 게시글이 보이지 않는 현상을 예로 들며, 이는 페이스북이 사용자의 인터넷 사용 기록을 분석하여 정보를 필터링하기 때문이라고 설명했다. 이로 인해 사용자는 자신과 다른 정치적 견해를 가진 사람들의 생각을 접할 기회를 잃게 된다.[23] 그는 필터링된 정보를 '정크푸드'에 비유하며, 건강한 정보 섭취의 중요성을 강조했다.

패리저는 필터 버블을 "알고리즘에 의해 제공되는 개인적인 정보 생태계"라고 정의했다.[8] 인터넷 기업은 사용자의 과거 검색 및 탐색 기록을 분석하여 타겟 광고를 제공하거나, 특정 정보가 검색 엔진 결과 페이지에 더 잘 보이도록 한다.[18] 이 과정은 사용자가 누구이며 무엇을 좋아하는지 파악하고, 그에 맞는 콘텐츠와 서비스를 제공하며, 적합성을 조정하는 세 단계로 이루어진다.[19]

비판과 우려

- 정보 편식 및 확증 편향: 필터 버블은 사용자가 이미 가지고 있는 생각과 신념을 강화하는 정보만 제공하여 확증 편향을 심화시킬 수 있다. 이는 다양한 관점을 접할 기회를 제한하고, 편협한 사고를 조장할 수 있다.[138]

- 가치관 왜곡: 알고리즘은 윤리성이나 가치 판단 능력이 없기 때문에, 필터링된 정보는 사용자의 가치관을 왜곡시킬 수 있다. 특히 정치적, 상업적 논리가 개입될 경우, 사용자는 자신도 모르는 사이에 편향된 정보를 받아들이게 될 수 있다.[138]

- 사회적 양극화: 필터 버블은 비슷한 생각을 가진 사람들끼리 모이게 하고, 다른 의견을 가진 사람들과의 소통을 단절시켜 사회적 양극화를 심화시킬 수 있다. 이는 "스플린터넷"(splinternet) 또는 "사이버 발칸화"(cyberbalkanization)라는 현상으로 이어진다.[28]

- 민주주의 위협: 필터 버블은 시민들이 다양한 정보를 접하고 합리적인 판단을 내리는 것을 방해하여 민주주의를 위협할 수 있다. 버락 오바마는 버락 오바마의 고별 연설에서 이와 유사한 개념을 "미국 민주주의에 대한 위협"으로 언급하기도 했다.[33]

- 윤리적 문제: 필터 버블은 개인 정보 침해, 정보 조작, 표현의 자유 제한 등 다양한 윤리적 문제를 야기할 수 있다. 특히 2016년 미국 대통령 선거 당시 캠브리지 애널리티카의 데이터 유출 사건은 필터 버블의 윤리적 문제를 부각시켰다.[103]

많은 사람들이 필터 버블의 존재를 인지하지 못하고 있으며, 이는 페이스북과 같은 소셜 미디어 플랫폼에서 더욱 두드러진다.[27] 이러한 상황은 사용자들이 자신의 의견과 다른 정보를 접할 기회를 더욱 제한하고, 편향된 시각을 강화할 수 있다.

패리저는 필터 버블의 잠재적 단점으로 "새로운 아이디어, 주제 및 중요한 정보로부터 우리를 차단하고"[24] "우리의 좁은 이익만이 존재하는 것처럼 보이게 만든다"[9]고 경고한다. 그는 Google과 Facebook이 사용자에게 "너무 많은 사탕과 너무 적은 당근"을 제공한다고 비판했다.[25] 그는 "웹의 보이지 않는 알고리즘 편집"이 새로운 정보 노출을 제한하고 전망을 좁힐 수 있다고 경고했다.[25] 파리저에 따르면 필터 버블의 해로운 영향은 "시민 담론을 약화시키고" 사람들을 "선전과 조작"에 더 취약하게 만들 수 있다.[9]

3. 1. 정보 편식과 확증 편향

'필터 버블'의 창시자인 엘리 패리저는 필터 버블이 확증 편향과 선택적 인지를 일으키는 정보 검열이 될 수 있다고 경고한다. 그는 자신의 저서 《생각 조종자들》에서 정보를 필터링하는 알고리즘에 정치적, 상업적 논리가 개입되면 정보 이용자들이 자신도 모르게 정보 편식을 하게 되고, 가치관 왜곡이 일어날 수 있다고 우려한다. 또한 알고리즘은 사람이 아니기 때문에 윤리성이나 가치 판단을 할 수 없다고 지적한다. 필터 버블은 한정된 정보만 제공하여 반대 성향의 글, 새로운 정보, 평소 보지 않던 분야의 뉴스 등을 접할 기회를 박탈하고, 이용자들의 지식과 가치관 확대를 방해할 수 있다.[138]엘리 패리저는 2011년 TED 강연에서 필터 버블에 대한 우려를 표하며, 필터링된 정보가 정크푸드와 같다고 비유했다. 그는 자신의 페이스북 '피드'에 보수 성향의 게시글이 보이지 않는 것은 페이스북이 자신의 인터넷 사용 기록을 분석하여 필터링했기 때문이며, 이로 인해 자신과 정치색이 다른 사람들의 생각을 알 수 없게 되었다고 지적한다.

패리저는 필터 버블을 "알고리즘에 의해 제공되는 개인적인 정보 생태계"라고 정의했다.[8] 인터넷 사용자의 과거 검색 및 탐색 기록은 사용자가 "링크 클릭, 친구 보기, 영화 대기열에 추가, 뉴스 기사 읽기" 등을 통해 관심사를 표시할 때 축적된다.[18] 인터넷 기업은 이 정보를 사용하여 사용자에게 타겟 광고를 제공하거나 특정 정보가 검색 엔진 결과 페이지에 더 잘 보이도록 한다.[18]

이 과정은 무작위적이지 않으며, 세 단계로 이루어진다. "먼저 사람들이 누구이고 무엇을 좋아하는지 알아낸다. 그런 다음 그들에게 가장 적합한 콘텐츠와 서비스를 제공한다. 마지막으로 적합성을 정확하게 조정한다. 당신의 정체성이 당신의 미디어를 형성한다."[19]

사이트 트래픽 측정을 통해 표시되는 링크 클릭 데이터에 접근하면 필터 버블이 집단적이거나 개별적일 수 있다.[21] 2011년 당시 한 엔지니어는 파리저에게 Google이 사용자의 검색 결과를 개인적으로 맞춤화하기 위해 사용 중인 컴퓨터의 종류와 사용자의 물리적 위치 등 57개의 데이터를 살펴본다고 말했다.[22]

파리저는 그의 저서 《필터 버블》에서 필터링된 검색의 잠재적인 단점으로 "새로운 아이디어, 주제 및 중요한 정보로부터 우리를 차단하고"[24] "우리의 좁은 이익만이 존재하는 것처럼 보이게 만든다"[9]고 경고한다. 필터 버블은 개인과 사회 모두에게 잠재적으로 해로우며, Google과 Facebook이 사용자에게 "너무 많은 사탕과 너무 적은 당근"을 제공한다고 비판했다.[25] 그는 "웹의 보이지 않는 알고리즘 편집"이 새로운 정보에 대한 노출을 제한하고 우리의 전망을 좁힐 수 있다고 경고했다.[25] 필터 버블의 해로운 영향은 "시민 담론을 약화시키고" 사람들을 "선전과 조작"에 더 취약하게 만들 가능성이 있다는 것이다.[9]

많은 사람들은 필터 버블이 존재한다는 사실을 알지 못한다. 가디언의 한 기사에서 "Facebook 사용자의 60% 이상이 Facebook의 큐레이션을 전혀 인식하지 못하고, 친구와 팔로우하는 페이지의 모든 스토리가 뉴스피드에 표시된다고 믿는다"는 사실을 언급했다.[27] Facebook은 "과거에 유사한 게시물과 어떻게 상호 작용했는지"를 고려하는 알고리즘을 통해 뉴스피드에 표시되는 내용을 결정한다.[27]

"메아리 방"과 "필터 버블"은 개인이 자신의 기존 신념과 편향을 강화하는 좁은 범위의 의견과 관점에 노출되는 상황을 설명하지만, 특히 소셜 미디어와 관련된 관행에서는 두 가지 개념 사이에 미묘한 차이가 있다.[34][35]

뉴스 미디어와 관련하여 메아리 방은 폐쇄 시스템 내에서 의사소통과 반복을 통해 신념이 증폭되거나 강화되는 상황을 은유적으로 설명하는 표현이다.[36][37] 선택적 노출 이론을 바탕으로, 이 용어는 소리가 빈 공간에서 반향하는 음향 메아리 방을 기반으로 한 은유이다. 소셜 미디어와 관련하여 이러한 상황은 사용자가 다른 사용자를 팔로우하거나 그룹을 선택하는 기능과 같이 특정 플랫폼의 사용자가 정보 소비를 적극적으로 선택할 수 있는 모든 과정을 설명하는 ''자기 선택적 개인화''의 명시적 메커니즘으로 이어진다.[38]

메아리 방에서는 사람들이 자신의 기존 견해를 강화하는 정보를 찾을 수 있으며, 무의식적인 확증 편향 행위일 수 있다. 이러한 피드백 조절은 정치적 및 사회적 양극화와 극단주의를 증가시킬 수 있다. 이는 사용자가 소셜 네트워크 내에서 동질적인 클러스터로 집합하게 하여 집단 극단화에 기여할 수 있다.[39] "메아리 방"은 사실적 근거 없이 개인의 신념을 강화한다. 개인은 동일한 관점을 인정하고 따르는 사람들로 둘러싸여 있지만, 메아리 방 밖으로 나갈 수 있는 능력도 가지고 있다.[40]

반면, 필터 버블은 사용자의 미디어 소비가 개인화된 알고리즘에 의해 생성되는 ''사전 선택적 개인화''의 암시적 메커니즘이다. 사용자가 보는 콘텐츠는 기존의 신념과 선호도를 강화하는 AI 기반 알고리즘을 통해 필터링되며, 반대되는 관점이나 다양한 관점을 배제할 수 있다. 이 경우 사용자는 더 수동적인 역할을 하고, 자신의 세계관에 도전하는 정보에 대한 노출을 자동으로 제한하는 기술의 피해자로 인식된다.[38] 그러나 일부 연구자들은 사용자가 여전히 검색 엔진과 소셜 미디어 네트워크와의 상호 작용을 통해 자신의 뉴스피드와 정보 출처를 선택적으로 큐레이팅하는 적극적인 역할을 하기 때문에 AI 기반 알고리즘에 의한 필터링 과정을 직접 지원하여 사실상 자기 분리 필터 버블에 참여한다고 주장한다.[41]

차이점에도 불구하고, 이러한 용어의 사용은 학문적 연구와 플랫폼 연구 모두에서 밀접하게 관련되어 있다. 필터링 알고리즘에 대한 접근성의 제한으로 인해 소셜 네트워크 연구에서 두 가지 개념을 구분하기 어려운 경우가 많으며, 이는 두 개념의 능동성을 비교 및 대조할 수 있도록 할 수 있다.[42]

알고리즘이 정치적 다양성을 제한하지만, 일부 필터 버블은 사용자의 선택의 결과이기도 하다.[53] 페이스북의 데이터 과학자들이 실시한 연구에 따르면, 사용자들은 자신의 이념과 같은 4명의 페이스북 친구들마다 대조되는 견해를 가진 친구를 1명씩 가지고 있다.[54][55] 뉴스 피드 알고리즘이 무엇이든 간에, 사람들은 비슷한 신념을 공유하는 사람들과 친구가 되거나 팔로우할 가능성이 더 높다.[54] 이 알고리즘의 특성상 사용자의 기록을 기반으로 스토리를 순위 매기기 때문에 "보수주의자의 경우 5%, 진보주의자의 경우 8%의 정치적으로 상반되는 콘텐츠가 감소"한다.[54] 그러나 사람들에게 상반되는 견해를 제공하는 링크를 클릭할 수 있는 옵션이 주어지더라도, 그들은 여전히 가장 많이 본 소스를 기본적으로 선택한다.[54] "[사용자의 선택은 보수주의자의 경우 17%, 진보주의자의 경우 6%의 상반되는 링크를 클릭할 가능성을 감소시킨다."[54]

Levi Boxell, Matthew Gentzkow, Jesse M. Shapiro의 최근 연구는 온라인 미디어가 정치적 양극화의 주요 원인이 아니라는 것을 시사한다.[57] 이 논문은 온라인 시간을 가장 적게 보내는 인구 집단에 의해 양극화가 주도되었다는 주장을 펼친다. 가장 큰 이념적 격차는 75세 이상의 미국인들 사이에서 나타나며, 2012년 기준으로 20%만이 소셜 미디어를 사용한다고 보고했다. 반면, 2012년 기준으로 18~39세 미국인의 80%는 소셜 미디어를 사용한다고 보고했다. 이 데이터는 젊은 세대가 온라인 미디어가 거의 존재하지 않았던 1996년과 비교하여 2012년에 더 양극화되지 않았다는 것을 시사한다. 이 연구는 연령대 간의 차이와 사람들이 자신의 선입견에 호소하는 정보를 찾기 때문에 뉴스 소비가 여전히 양극화되는 방식을 강조한다.

독일의 2020년 연구는 빅 파이브 심리학 모델을 사용하여 개인의 성격, 인구 통계 및 이념이 사용자 뉴스 소비에 미치는 영향을 테스트했다.[58] 사용자가 소비하는 뉴스 소스의 수가 필터 버블에 걸릴 가능성에 영향을 미친다는 개념(미디어 다양성이 높을수록 가능성이 줄어듦)을 기반으로 한 연구 결과는 특정 인구 통계(고령 및 남성)와 특정 성격 특성(개방성이 높음)이 개인이 소비하는 뉴스 소스의 수와 양의 상관관계가 있다는 것을 시사한다. 또한 이 연구는 미디어 다양성과 사용자가 극우 권위주의에 얼마나 동조하는지 사이에 부정적인 이념적 연관성을 발견했다.

페이스북 연구에 따르면, 알고리즘이 뉴스 피드 필터링에 사람들이 생각하는 것만큼 큰 역할을 했는지 여부는 "결론적이지 않다"[59]. 이 연구는 또한 "개인적인 선택" 또는 확증 편향이 뉴스 피드에서 필터링되는 내용에도 마찬가지로 영향을 미친다는 것을 발견했다.[59] 일부 사회 과학자들은 알고리즘과 개인적인 선택이 뉴스 피드를 필터링하는 데 함께 작용한다는 것이 필터 버블에 항의하는 요점이기 때문에 이러한 결론을 비판했다.[60]

이 연구에 따르면 평균 사용자의 페이스북 친구 중 약 15~20%만이 정치적 스펙트럼의 반대편에 가입했지만, 복스의 Julia Kaman은 이것이 견해 다양성에 잠재적으로 긍정적인 영향을 미칠 수 있다고 추측했다. 이 연구에 따르면 "진보주의자들이 본 뉴스 항목의 24%는 보수적인 경향이 있었고, 보수주의자들이 본 뉴스의 38%는 진보적인 경향이 있었다." [62] "진보주의자들은 보수적인 대응자와 비교하여 상대편의 정보를 공유하는 친구가 더 적은 경향이 있다." [63] 이러한 상호 작용은 사용자의 견해를 조절할 수 있는 다양한 정보와 출처를 제공할 수 있다.

마찬가지로, 뉴욕대학교의 트위터 필터 버블 연구는 "개인은 이제 뉴스 이벤트에 대한 더 넓은 범위의 관점에 접근할 수 있으며, 이 정보의 대부분은 전통적인 채널을 통해서가 아니라 정치적 행위자로부터 직접 또는 친구나 친척을 통해 얻는다. 게다가 소셜 미디어의 상호 작용적인 특성은 개인이 약한 사회적 유대 관계를 가진 사람들을 포함하여 동료들과 정치적 사건을 논의할 수 있는 기회를 만든다."라고 결론지었다.[64]

이 문제의 한 가지 원인이자 가능한 해결책은 온라인 콘텐츠에서 감정의 역할이다. 2018년 연구에 따르면 메시지의 서로 다른 감정이 양극화 또는 수렴으로 이어질 수 있다는 것을 보여준다. 기쁨은 감정적 양극화에 만연하지만, 슬픔과 두려움은 감정적 수렴에 중요한 역할을 한다.[65]

소셜 봇은 서로 다른 연구자들이 필터 버블과 에코 체임버에 기인하는 양극화 및 관련 효과를 테스트하는 데 사용되었다.[66][67] 2018년 연구에서는 트위터에서 소셜 봇을 사용하여 사용자가 의도적으로 당파적인 관점에 노출되는 것을 테스트했다.[66] 주요 결과 중 하나는 다른 견해에 노출된 후(봇이 제공), 자칭 공화당원은 더 보수적으로 되었지만, 자칭 진보주의자는 이념적 변화가 거의 없거나 전혀 없었다는 것이다.

2018년 6월, DuckDuckGo 플랫폼은 Google 웹 브라우저 플랫폼에 대한 연구를 수행했다. 이 연구에서 미국 본토 여러 지역의 성인 87명이 정확히 같은 시간에 이민, 총기 규제, 예방 접종이라는 세 가지 키워드를 구글링했다. 개인 정보 보호 모드에서도 대부분의 사람들은 자신에게만 고유한 결과를 보았다. Google은 다른 참가자에게는 포함하지 않은 특정 링크를 일부에게 포함했으며, 뉴스 및 비디오 정보 상자는 상당한 차이를 보였다. Google은 검색 엔진 결과 페이지(SERP) 개인화가 대부분 신화라고 말하며 이러한 결과를 공개적으로 반박했다. Google 검색 담당자인 Danny Sullivan은 "수년에 걸쳐 Google 검색이 너무 많이 개인화되어 동일한 쿼리에 대해 서로 다른 사람들이 서로 상당히 다른 결과를 얻을 수 있다는 신화가 생겨났습니다. 이것은 사실이 아닙니다. 결과는 다를 수 있지만 일반적으로 개인화되지 않은 이유 때문입니다."라고 말했다.[68]

필터 버블이 작동하면 과학자들이 '와우' 순간이라고 부르는 특정 순간을 만들 수 있다. '와우' 순간은 현재 행동이나 개체의 현재 사용과 관련된 기사, 광고, 게시물 등이 컴퓨터에 나타날 때 발생한다. 과학자들은 젊은 여성이 커피를 마시는 일상적인 활동을 하던 중 컴퓨터를 열고 자신이 마시고 있던 커피와 같은 브랜드의 커피 광고를 보고 이 용어를 발견했다. "오늘 아침 커피를 마시면서 페이스북을 열었는데, 네스프레소 광고가 두 개나 있더군요. 자신이 마시고 있는 제품이 눈앞의 화면에 뜨는 '와우' 순간이었죠."[69]

3. 2. 가치관 왜곡 및 사회적 양극화

'필터 버블' 창시자인 엘리 패리저는 필터 버블이 확증 편향과 선택적 인지를 일으켜 정보 이용자들이 자신도 모르게 정보 편식을 하게 되고, 가치관 왜곡이 일어날 수 있다고 우려한다. 알고리즘은 윤리성이나 가치 판단을 할 수 없으며, 필터 버블은 한정된 정보만 제공하여 반대 성향의 글이나 새로운 정보를 접할 기회를 박탈하고, 지식과 가치관 확대를 방해할 수 있다고 지적한다.[138]엘리 패리저는 2011년 TED 강연에서 자신의 페이스북 '피드'에 보수 성향의 게시글이 나타나지 않는 것은 페이스북이 자신의 인터넷 사용 기록을 필터링했기 때문이며, 이로 인해 정치색이 다른 사람들의 생각을 알 수 없게 되었다고 말한다. 그는 필터링된 정보를 정크푸드에 비유하기도 했다.

파리저는 필터 버블을 "알고리즘에 의해 제공되는 개인적인 정보 생태계"라고 정의했다.[8] 사용자가 특정 주제에 관심을 보이면 인터넷 기업은 이 정보를 사용하여 타겟 광고를 제공하거나 특정 정보가 검색 결과 페이지에 더 두드러지게 나타나도록 한다.[18]

파리저는 필터 버블의 잠재적 단점으로 "새로운 아이디어, 주제 및 중요한 정보로부터 우리를 차단"하고[24] "우리의 좁은 이익만이 존재하는 것처럼 보이게" 만든다고[9] 경고한다. 그는 Google과 Facebook이 사용자에게 "너무 많은 사탕과 너무 적은 당근"을 제공한다고 비판하며,[25] "시민 담론을 약화시키고" 사람들을 "선전과 조작"에 더 취약하게 만들 수 있다고 우려한다.[9]

필터 버블은 "스플린터넷"(splinternet) 또는 "사이버 발칸화"(cyberbalkanization)라고 불리는 현상을 악화시킨다.[28] 이는 인터넷이 서로 비슷한 생각을 가진 사람들의 하위 그룹으로 나뉘어져 자체 온라인 커뮤니티 내에서 고립되고 다른 견해에 노출되지 않는 현상을 말한다. "사이버 발칸화"라는 용어는 1996년에 만들어졌다.[29][30][31]

버락 오바마는 버락 오바마의 고별 연설에서 필터 버블과 유사한 개념을 "미국 민주주의에 대한 위협"으로 규정했다.[33]

필터 버블은 미디어 개인화로 인해 발생하며, 사용자들을 덫에 가둘 수 있다. AI를 사용하여 제공되는 콘텐츠를 개인화하면 사용자는 자신의 견해를 강화하는 콘텐츠만을 보게 되어 반대되는 견해에 도전하지 않게 될 수 있다. 페이스북과 같은 소셜 미디어 웹사이트는 사용자가 콘텐츠의 출처를 파악하기 어렵게 만들어 사용자가 스스로 출처의 신뢰성 여부를 판단하게 만들 수 있다.[105] 이는 사람들이 듣고 싶은 것만 듣는 데 익숙해져 반대되는 견해를 접했을 때 더 급진적으로 반응하게 만들 수 있다. 필터 버블은 사람들이 반대되는 견해를 잘못된 것으로 여기게 만들 수 있으며, 따라서 미디어가 소비자에게 견해를 강요할 수 있도록 허용할 수 있다.[106][105][107]

3. 3. 민주주의 위협

'필터 버블'이라는 용어를 만든 인터넷 운동가 엘리 패리저는 필터 버블이 확증 편향과 선택적 인지를 일으켜 일종의 정보 검열이 될 수 있다고 우려한다. 그는 저서 《생각 조종자들》에서 알고리즘에 정치적, 상업적 논리가 개입되면, 필터링된 정보만 받는 이용자들은 자신도 모르게 정보 편식을 하고, 가치관 왜곡이 일어날 수 있다고 지적한다. 또한, 알고리즘은 사람이 아니기에 윤리성이나 가치 판단을 할 수 없으며, 필터 버블은 한정된 정보만 제공하여 반대 성향의 글, 새로운 정보, 평소 보지 않던 분야의 뉴스 등을 접할 기회를 박탈해 지식과 가치관 확대를 방해한다고 말한다.[138]엘리 패리저는 2011년 TED 강연에서 필터 버블에 대한 우려를 표하며, 자신의 페이스북 '피드'에 보수 성향 게시글이 보이지 않는 것은 페이스북이 자신의 인터넷 사용 기록을 필터링했기 때문이라고 말했다. 이로 인해 정치색이 다른 사람들의 생각을 알 수 없게 되었다고 지적하며, 필터링된 정보를 정크푸드에 비유하기도 했다.

패리저는 필터 버블을 "알고리즘에 의해 제공되는 개인적인 정보 생태계"라고 정의했다.[8] 인터넷 사용자의 과거 검색 및 탐색 기록은 사용자가 "링크 클릭, 친구 보기, 영화 대기열에 추가, 뉴스 기사 읽기" 등을 통해 관심사를 표시할 때 축적된다.[18] 인터넷 기업은 이 정보를 사용해 타겟 광고를 제공하거나, 특정 정보가 검색 결과 페이지에 더 잘 보이게 한다.[18]

패리저는 이 과정이 세 단계로 이루어진다고 말한다. "먼저 사람들이 누구이고 무엇을 좋아하는지 알아낸다. 그런 다음 그들에게 가장 적합한 콘텐츠와 서비스를 제공한다. 마지막으로 적합성을 정확하게 조정한다. 당신의 정체성이 당신의 미디어를 형성한다."[19]

사이트 트래픽 측정으로 표시되는 링크 클릭 데이터에 접근하면 필터 버블이 집단적이거나 개별적일 수 있다.[21] 2011년 당시 한 엔지니어는 파리저에게 Google이 사용 중인 컴퓨터 종류, 사용자의 물리적 위치 등 쿠키가 아닌 데이터를 포함하여 57개의 데이터를 통해 검색 결과를 개인 맞춤화한다고 말했다.[22]

파리저는 2011년 5월 TED 강연에서 필터 버블 작동 방식과 볼 수 있는 곳에 대한 예시를 제시했다. 필터 버블 효과를 보여주기 위해 친구들에게 Google에서 "이집트"를 검색하고 결과를 보내달라고 요청했다. 두 친구의 첫 페이지 결과를 비교했을 때, 한 친구의 결과에는 2011년 이집트 혁명에 대한 정보 링크가 있었지만, 다른 친구의 결과에는 없었다.[23]

파리저는 저서 《필터 버블》에서 필터링된 검색의 잠재적 단점으로 "새로운 아이디어, 주제 및 중요한 정보로부터 우리를 차단하고"[24] "우리의 좁은 이익만이 존재하는 것처럼 보이게 만든다"[9]고 경고한다. 필터 버블은 개인과 사회 모두에게 잠재적으로 해롭다. 그는 Google과 Facebook이 사용자에게 "너무 많은 사탕과 너무 적은 당근"을 제공한다고 비판했다.[25] 그는 "웹의 보이지 않는 알고리즘 편집"이 새로운 정보 노출을 제한하고 전망을 좁힐 수 있다고 경고했다.[25] 파리저에 따르면 필터 버블의 해로운 영향은 "시민 담론을 약화시키고" 사람들을 "선전과 조작"에 더 취약하게 만들 수 있다.[9]

많은 사람들은 필터 버블이 존재한다는 것을 모른다. 가디언의 한 기사에서는 "Facebook 사용자의 60% 이상이 Facebook의 큐레이션을 전혀 인식하지 못하고, 친구와 팔로우하는 페이지의 모든 스토리가 뉴스피드에 표시된다고 믿는다"고 언급했다.[27] Facebook은 "과거에 유사한 게시물과 어떻게 상호 작용했는지"를 고려하는 알고리즘을 통해 뉴스피드에 표시되는 내용을 결정한다.[27]

인터넷 검색 사이트는 쿠키, 핑거프린팅 등 메커니즘을 사용해 사용자 위치, 과거 클릭 기록, 검색 기록 등 개인 정보를 파악한다.[109] 그리고 각 사용자의 개인 정보를 알고리즘에 따라 분석하여 보고 싶어할 정보를 선택적으로 추정하고, 보고 싶어하지 않을 정보는 차단한다.[110] 각 사용자에게 최적화된, 보고 싶어할 검색 결과만 반환한다.[111] Google이나 Facebook 등 대부분 웹사이트에서 표준으로 도입되어, 같은 "인터넷"을 보고 있다고 생각해도 사람들은 "필터"를 통해 개인화된 세계를 본다.[112]

원하는 검색 결과가 나오는 알고리즘을 가진 웹사이트일수록 사용자에게 좋은 웹사이트로 평가되므로 각 사이트의 검색 알고리즘은 더욱 발전했지만, 검색 사이트의 알고리즘이 더욱 발전하고 원하는 검색 결과가 나오게 되면, 궁극적으로는 자신이 보고 싶은 정보[113] 이외의 것을 인터넷에서 볼 수 없게 된다. 그리고 자신의 관점과 맞지 않는 정보로부터 고립되어 같은 의견을 가진 사람들끼리 무리를 이루게 되고, 각 집단마다 문화적, 사상적 막(버블) 속에 고립되어 간다.

이 용어는 인터넷 환경 운동가인 일라이 패리서가 2011년에 출판한 『The Filter Bubble』(한국어 번역본은 『닫힌 인터넷』, 2012년 출간)에서 만들었다. 이 책에 따르면, 사용자는 점차 자신의 생각과 대립되는 관점의 정보에 접할 수 없게 되고, 자신의 정보 막 속에서 지적 고립에 빠진다. 일라이 패리서는 2016년에 "『좋아요!』를 누른 사람들의 글만 보고 있다 보니, 당신이 극도로 싫어하는 사람이 대통령[114]이 되어 있는 것을 보고 놀라게 될 거예요"라고 말했다.[115]

필터 버블은 "에코 체임버"처럼, 모든 방향에서 자신과 같은 의견이 돌아오는 폐쇄된 공간에 있게 된 결과, 다양한 사람들의 의견을 듣고 다양한 생각을 알게 되는 것이 아니라, 단순히 자신의 의견이 증폭·강화될 뿐인 "에코 체임버 현상"과도 관련이 깊다. 불특정 다수를 대상으로 하는 광고나 정치적 주장의 경우, 검색 결과에서 자신이 전달하고자 하는 정보를 상위에 표시하는 수단으로 SEO가 있지만, 파리서는 필터 버블 개념을 “(검색 엔진의) 알고리즘에 의해 초래되는 정보의 개인적 생태계”로 정의한다.[116] 같은 현상을 나타내는 데 “이데올로기적 틀(ideological frame)”[117] 또는 “인터넷 검색 시 당신을 감싸고 있는 비유적인 구체”[118] 와 같은 다른 표현이 사용되기도 했다.

인터넷 이용자가 “링크를 클릭하고, 친구를 방문하고, 동영상을 재생 대기열에 추가하고, 뉴스를 읽는다” 등 특정 주제에 관심을 보이면 과거 검색 기록이 축적된다.[118] 그러면 인터넷 사업자는 이러한 정보를 이용하여 해당 사용자를 대상으로 광고를 게재하거나 검색 결과가 더욱 눈에 띄도록 한다.[118]

파리서는 저서 『필터 버블』에서 필터링된 검색의 잠재적 단점은 “우리를 새로운 아이디어, 주제, 중요한 정보로부터 차단한다”[120], “우리의 좁은 사욕이 세상의 전부라는 인상을 준다”[117]고 경고한다. 이는 개인과 사회 모두에게 잠재적으로 해롭다고 한다. 그는 구글과 페이스북을 “사용자에게 과자만 주고 채소는 거의 주지 않는다”고 비판했다.[121] 파리서에 따르면, 필터 버블은 “시민적 대화를 은밀히 파괴”하고 사람들을 “선전과 정보 조작”에 대해 더욱 무력하게 만들기 때문에 필터 버블의 해로운 영향은 사회 전체에 해를 끼친다고 한다.[117]

필터 버블은 스플린터넷(Splinternet) 또는 사이버 발칸화[122]라고 불리는 현상을 악화시킨다. 사이버 발칸화는 인터넷이 자신의 온라인 커뮤니티에 고립되어 다른 관점에 접하지 못하게 된, 유사한 사상을 가진 사람들로 구성된 하위 그룹으로 분열되는 것을 말한다. 사이버 발칸화라는 단어는 1996년에 만들어진 신조어이다.[123][124][125]

3. 4. 윤리적 문제

엘리 패리저는 '필터 버블'이라는 용어를 만든 인터넷 운동가로, 필터 버블이 확증편향과 선택적 인지를 일으켜 정보 검열의 위험을 초래할 수 있다고 지적한다. 그는 저서 《생각 조종자들》에서 정보를 필터링하는 알고리즘에 정치적, 상업적 논리가 개입되면 정보 이용자들이 자신도 모르게 정보 편식을 하게 되고, 가치관 왜곡이 일어날 수 있음을 우려한다.[138]패리저는 2011년 TED 강연에서 필터 버블에 대한 우려를 표하며, 필터링된 정보는 정크푸드에 비유하기도 하였다. 그는 진보적 성향의 자신의 페이스북 '피드'에 보수적 성향의 게시글이 필터링되어 정치색이 다른 사람들의 생각을 알 수 없게 되었다고 지적했다.[23]

패리저는 필터 버블을 "알고리즘에 의해 제공되는 개인적인 정보 생태계"라고 정의했다.[8] 인터넷 사용자의 과거 검색 기록은 사용자가 링크 클릭, 친구 보기, 영화 대기열 추가, 뉴스 기사 읽기 등으로 특정 주제에 관심을 보일 때 축적된다.[18] 인터넷 기업은 이 정보를 사용하여 사용자에게 타겟 광고를 제공하거나 특정 정보가 검색 결과 페이지에 더 잘 보이게 한다.[18]

이 과정은 무작위적이지 않으며, 세 단계로 이루어진다. "먼저 사람들이 누구이고 무엇을 좋아하는지 알아낸다. 그런 다음 그들에게 가장 적합한 콘텐츠와 서비스를 제공한다. 마지막으로 적합성을 정확하게 조정한다. 당신의 정체성이 당신의 미디어를 형성한다."[19]

Dictionary.com영어에서 "우울증"과 같은 단어를 검색하면 최대 223개의 추적 쿠키와 비콘이 설치되어 다른 웹사이트에서 항우울제를 타겟팅할 수 있다. CNN에서 야후와 MSN에 이르기까지 상위 50개 인터넷 사이트는 평균 64개의 데이터가 포함된 쿠키와 개인 추적 비콘을 설치한다.[20]

필터 버블은 집단적이거나 개별적일 수 있다.[21] 2011년 당시 한 엔지니어는 파리저에게 Google이 사용 중인 컴퓨터의 종류와 사용자의 물리적 위치와 같은 쿠키가 아닌 데이터를 포함하여 사용자의 검색 결과를 개인적으로 맞춤화하기 위해 57개의 서로 다른 데이터를 살펴본다고 말했다.[22]

파리저는 저서 《필터 버블》에서 필터링된 검색은 "새로운 아이디어, 주제 및 중요한 정보로부터 우리를 차단하고"[24] "우리의 좁은 이익만이 존재하는 것처럼 보이게 만든다"[9]고 경고한다. 필터 버블은 개인과 사회 모두에게 잠재적으로 해롭다. 그는 Google과 Facebook이 사용자에게 "너무 많은 사탕과 너무 적은 당근"을 제공한다고 비판했다.[25] 그는 "웹의 보이지 않는 알고리즘 편집"이 새로운 정보에 대한 노출을 제한하고 우리의 전망을 좁힐 수 있다고 경고했다.[25] 필터 버블의 해로운 영향은 "시민 담론을 약화시키고" 사람들을 "선전과 조작"에 더 취약하게 만들 가능성이 있다는 것이다.[9]

많은 사람들은 필터 버블이 존재한다는 사실을 알지 못한다. 가디언의 한 기사에서 "Facebook 사용자의 60% 이상이 Facebook의 큐레이션을 전혀 인식하지 못하고, 친구와 팔로우하는 페이지의 모든 스토리가 뉴스피드에 표시된다고 믿는다"는 사실을 언급했다.[27]

엘리 패리서는 저서 『필터 버블: 인터넷이 당신에게 숨기는 것』에서[72] 필터 버블이 사회적 동질성을 강화하여 서로 다른 관심사와 견해를 가진 사람들 간의 유대감을 약화시킨다고 주장한다.[73]

사용자는 필터 버블을 깨기 위해 자신이 접하는 정보를 의식적으로 평가하고 다양한 콘텐츠를 이용하고 있는지 비판적으로 생각하는 노력을 할 수 있다.[74] 또한 검증되지 않거나 신뢰할 수 없는 뉴스 출처를 피하고, 팩트 체크 사이트를 사용할 수 있다.[75]

일부 브라우저 플러그인은 사람들이 필터 버블에서 벗어나 자신의 관점을 인식하도록 돕는다. 이러한 미디어는 사용자의 신념과 의견과 상반되는 콘텐츠를 보여준다. "Read Across the Aisle"과 같은 뉴스 앱은 사용자의 독서 패턴이 한쪽으로 치우친 경우 다른 관점을 읽도록 유도한다.[77]

웹 기반 광고는 사용자에게 동일한 콘텐츠를 더 많이 노출함으로써 필터 버블의 효과를 증폭시킬 수 있다. 사용자는 검색 기록을 삭제하고, 타겟 광고를 끄고, 브라우저 확장 프로그램을 다운로드하여 많은 광고를 차단할 수 있다. 일부 사용자는 YaCy, DuckDuckGo, Qwant, Startpage.com, Disconnect, Searx와 같은 익명 또는 비개인화된 검색 엔진을 사용한다.

유럽 연합은 필터 버블의 영향을 줄이기 위한 조치를 취하고 있다. 유럽 의회는 필터 버블이 사람들이 다양한 뉴스에 접근하는 능력에 어떤 영향을 미치는지에 대한 조사를 후원하고 있다.[79] 또한 시민들에게 소셜 미디어에 대한 교육을 목표로 하는 프로그램을 도입했다.[80] 미국에서는 CSCW 패널이 뉴스 집계 앱을 사용하여 미디어 소비자의 뉴스 섭취를 확대할 것을 제안한다.

학자들은 개인의 자유, 보안, 정보 편향과 관련하여 소셜 미디어 사용자에게 미치는 필터 버블의 영향을 고려하기 시작했다.[88] 소셜 미디어와 개인 맞춤형 검색 사이트의 필터 버블은 사용자가 보는 콘텐츠를 결정할 수 있으며, 종종 알고리즘으로 인해 사용자의 동의나 인식 없이 이루어진다.[87]

기술자, 소셜 미디어 엔지니어 및 컴퓨터 전문가는 필터 버블의 만연에 대해 조사했다.[90] 마크 저커버그와 엘리 파라이저는 개인 정보 보호 및 정보 양극화의 위험에 대해 우려를 표명했다.[91][92]

일부 학자들은 필터 버블이 개인 및 사회적 안녕에 미치는 영향, 건강 정보를 전파하고 인터넷 검색 엔진이 건강 관련 행동을 변경할 수 있는 잠재적 영향에 대해 우려를 표명했다.[15][16][17][93]

2016년 미국 대통령 선거를 고려하여 학자들은 필터 버블이 민주주의 및 민주적 과정에 미치는 영향과 "이데올로기적 미디어"의 부상에 대해서도 우려를 표명했다.[11]

2018년 3월 캠브리지 애널리티카가 2016년 대통령 선거 기간 동안 최소 8700만 개의 페이스북 프로필에 대한 사용자 데이터를 수집하고 사용한 사실이 밝혀짐으로써 필터 버블의 윤리적 함의가 강조되었다.[103]

4. 사이버 발칸화

필터 버블은 "스플린터넷"(splinternet) 또는 "사이버 발칸화"(cyberbalkanization)라고 불리는 현상을 악화시키는 것으로 묘사되어 왔다.[28] 이는 인터넷이 서로 비슷한 생각을 가진 사람들의 하위 그룹으로 나뉘어져 자체 온라인 커뮤니티 내에서 고립되고 다른 견해에 노출되지 않는 현상을 말한다. 이러한 우려는 공개적으로 접근 가능한 인터넷의 초기부터 제기되었으며, "사이버 발칸화"라는 용어는 1996년에 만들어졌다.[29][30][31]

사이버 발칸화는 인터넷이 자신의 온라인 커뮤니티에 고립되어 다른 관점에 접하지 못하게 된, 유사한 사상을 가진 사람들로 구성된 하위 그룹으로 분열되는 것을 말한다. 사이버 발칸화라는 단어는 1996년에 만들어진 신조어이다.[123][124][125]

5. 연구 및 대응

필터링 효과는 브라우저를 시크릿 모드(개인 정보 보호 모드)로 열고 일반 모드와 비교하여 확인할 수 있다. 시크릿 모드에서는 캐시, 쿠키, 방문 기록 등이 창을 닫을 때마다 삭제되므로, 과거 검색 기록의 영향 없이 검색할 수 있다.[117]

분석가 제이콥 바이스버그(Jacob Weisberg)는 슬레이트지 기사에서 서로 다른 이데올로기적 배경을 가진 5명이 같은 검색을 한 결과, 거의 동일한 결과가 나왔다는 실험 결과를 발표했다. 이를 통해 모든 사람이 “나만을 위한 신문(en:Daily Me)”에 길들여져 있다는 것은 과장이라고 주장했다.[117]

와튼 스쿨의 과학 연구에서는 온라인 음악 취향에 관한 특정 개인에게 특화된 추천은 필터가 실제로는 분열이 아니라 오히려 집단을 만드는 데 작용한다는 것을 알아냈다. 소비자는 필터를 사용하여 취향을 제한하는 것이 아니라 확장하고 있었다.[126]

문예 비평가 폴 부틴(Paul Boutin)은 서로 다른 검색 기록을 가진 사람들로 비슷한 실험을 한 결과, 바이스버그와 비슷한 결과를 얻었다.[127]

하버드 대학교 조나단 지트라인(Jonathan Zittrain) 법학 교수는 개인 필터가 구글 검색 결과를 얼마나 왜곡하는지에 대해 논의하며, "검색 개인화의 영향은 미미했다"고 말했다.[117]

구글의 개인화 기능은 웹 기록을 삭제하는 등의 방법으로 사용자가 선택하면 중지시킬 수 있다는 보고도 있다.[128] 구글 대변인은 알고리즘이 구글 검색에 "개인화를 제한하고 다양성을 증진하기 위해" 의도적으로 추가되었다고 시사했다.[117]

5. 1. 학계 및 미디어의 반응

개인 맞춤형 필터링의 범위와 그 활동의 유익성 또는 유해성에 대한 보고는 상충된다. 분석가 제이콥 와이스버그(Jacob Weisberg)는 2011년 6월 슬레이트(Slate)에 기고한 글에서 파리저(Pariser)의 이론을 검증하기 위한 소규모 비과학적 실험을 진행했다. 서로 다른 이념적 배경을 가진 5명의 동료가 "존 보에너(John Boehner)", "버니 프랭크(Barney Frank)", "라이언 계획(Ryan plan)", "오바마케어(Obamacare)"에 대한 일련의 검색을 수행하고 와이스버그에게 검색 결과 스크린샷을 보냈다. 결과는 사람마다 사소한 차이만 있었으며, 그 차이가 이념과 관련이 있는 것으로 보이지는 않았다. 와이스버그의 결론은 필터 버블이 작용하지 않았으며, 대부분의 인터넷 사용자가 "데일리 미(Daily Me)"의 먹이통에서 먹이를 먹고 있다는 생각은 과장되었다고 했다.[9] 와이스버그는 구글에 의견을 요청했고, 구글 대변인은 알고리즘이 의도적으로 "개인화를 제한하고 다양성을 증진"하도록 설계되었다고 말했다.[9] 서평가 폴 부탱(Paul Boutin)은 서로 다른 검색 이력을 가진 사람들을 대상으로 와이스버그와 유사한 실험을 했고, 역시 서로 다른 검색자들이 거의 동일한 검색 결과를 받았다는 것을 발견했다.[6] 기자 페르 그랑크비스트(Per Grankvist)는 구글의 프로그래머들과 비공개 인터뷰를 통해 사용자 데이터가 검색 결과를 결정하는 데 더 큰 역할을 했지만 구글은 테스트를 통해 검색어가 어떤 결과를 표시할지 결정하는 가장 좋은 요소임을 발견했다는 것을 알아냈다.[44]구글 및 기타 사이트가 사용자에 대한 방대한 "개인 정보 파일"을 보유하고 있으며, 원한다면 개인의 인터넷 경험을 더욱 개인화할 수 있다는 보고가 있다. 예를 들어, 구글은 개인 구글 계정이 없거나 로그인하지 않은 경우에도 사용자의 이력을 추적하는 기술을 보유하고 있다.[6] 한 보고서에 따르면 구글은 Gmail, Google Maps 및 검색 엔진 이외의 다른 서비스와 같은 다양한 출처에서 수집한 "10년치" 정보를 수집했다고 한다.[10] 그러나 반대되는 보고서에서는 인터넷 회사가 사용 가능한 방대한 데이터에도 불구하고 각 사용자에 맞게 인터넷을 개인화하는 것이 기술적으로 어렵다고 했다. CNN의 분석가 더그 그로스(Doug Gross)는 필터링된 검색이 시민보다 소비자에게 더 유용하며, "피자"를 찾는 소비자가 개인화된 검색을 기반으로 지역 배달 옵션을 찾고 먼 피자 가게를 적절하게 걸러낼 수 있도록 도와준다고 제안했다.[10] 워싱턴 포스트, 뉴욕 타임스 등의 기관은 사용자가 좋아하거나 동의할 가능성이 높은 검색 결과를 맞춤화하기 위해 새로운 개인화된 정보 서비스를 만드는 실험을 했다.[9]

펜실베이니아 대학교 와튼 스쿨의 과학 연구는 개인화된 추천(personalized recommendations) 시스템을 분석하여 이러한 필터가 온라인 음악 취향에서 분열이 아닌 공통성을 만들어낼 수 있다는 사실을 발견했다.[45] 소비자들은 이러한 필터를 취향을 제한하기 위해서가 아니라 확장하기 위해 사용하는 것으로 알려져 있다.[45] 하버드 법대 교수인 조나단 짓트라인은 개인화 필터가 구글 검색 결과를 왜곡하는 정도에 대해 이의를 제기하며 "검색 개인화의 영향은 미미하다"고 말했다.[9] 또한 구글은 사용자가 원하는 경우 검색 기록을 삭제하고 구글이 향후 검색 키워드와 방문한 링크를 기억하지 않도록 설정하여 개인화 기능을 끌 수 있는 기능을 제공한다.[46][6]

인터넷 정책 리뷰(Internet Policy Review)(Alexander von Humboldt Institute for Internet and Society)의 연구는 여러 학문 분야에서 필터 버블에 대한 명확하고 검증 가능한 정의가 부족하다는 점을 다루었다. 이로 인해 연구자들이 서로 다른 방식으로 필터 버블을 정의하고 연구하는 경우가 많다.[47] 이후 이 연구는 여러 학문 분야에서 필터 버블의 존재에 대한 경험적 데이터가 부족하다는 점을 설명했으며[48] 필터 버블에 기인하는 효과는 알고리즘보다는 기존의 이데올로기적 편향에서 더 많이 비롯될 수 있다고 제안했다. 유사한 견해는 다른 학술 프로젝트에서도 찾아볼 수 있으며, 이러한 프로젝트는 필터 버블의 정의와 이와 관련된 이데올로기적 및 기술적 요인 간의 관계에 대한 우려 사항도 다룬다.[49] 필터 버블에 대한 비판적 검토는 "필터 버블 논제는 종종 강력하지만 동시에 매우 변화 가능한 의견을 가진 특별한 종류의 정치적 인간을 가정"하며, "사람들이 콘텐츠를 선택할 때는 적극적인 주체이지만 알고리즘에 의해 큐레이션된 추천 콘텐츠에 노출되면 수동적인 수용자가 된다는 역설"이라고 제안했다.[50]

옥스퍼드 대학교, 스탠퍼드 대학교, 마이크로소프트 연구원들이 진행한 연구는 2013년 3월부터 5월까지 인터넷 익스플로러용 빙 툴바(Bing Toolbar) 추가 기능을 사용하는 120만 명의 미국 사용자의 검색 기록을 조사했다. 연구진은 활동적인 뉴스 소비자인 5만 명의 사용자를 선정한 다음, 사용자 IP 주소와 관련된 카운티의 유권자 대다수가 2012년 대통령 선거에서 오바마 또는 롬니에게 투표했는지 여부를 기준으로 방문한 뉴스 매체가 좌파 또는 우파 성향인지 분류했다. 그런 다음 뉴스 기사가 게시자 사이트를 직접 방문했는지, 구글 뉴스 집계 서비스, 웹 검색 또는 소셜 미디어를 통해 접근했는지 여부를 확인했다. 연구진은 웹 검색과 소셜 미디어가 이데올로기적 분리를 초래하지만, 온라인 뉴스 소비의 대부분은 사용자가 좌파 또는 우파 성향의 주류 뉴스 사이트를 직접 방문하여 결과적으로 정치적 스펙트럼의 한쪽 편에서 나온 견해에 거의 독점적으로 노출되는 것으로 구성되어 있음을 발견했다. 이 연구의 한계에는 인터넷 익스플로러 사용자가 일반 인터넷 사용자보다 연령이 높은 경향이 있다는 점과 같은 선택 문제, 빙 툴바 사용 및 개인 정보에 대해 덜 우려하는 사용자의 검색 기록 공유(자발적 또는 무의식적), 좌파 성향 간행물의 모든 기사가 좌파 성향이고 우파 성향 간행물의 모든 기사가 우파 성향이라는 가정, 그리고 활동적인 뉴스 소비자가 아닌 사용자가 소셜 미디어를 통해 뉴스의 대부분을 얻을 수 있으며, 따라서 뉴스 간행물을 선택하여 편향을 자체적으로 선택하는 사용자(간행물의 편향을 알고 있다고 가정)보다 사회적 또는 알고리즘 편향(algorithmic bias)의 영향을 더 강하게 받을 수 있다는 가능성이 포함된다.[51]

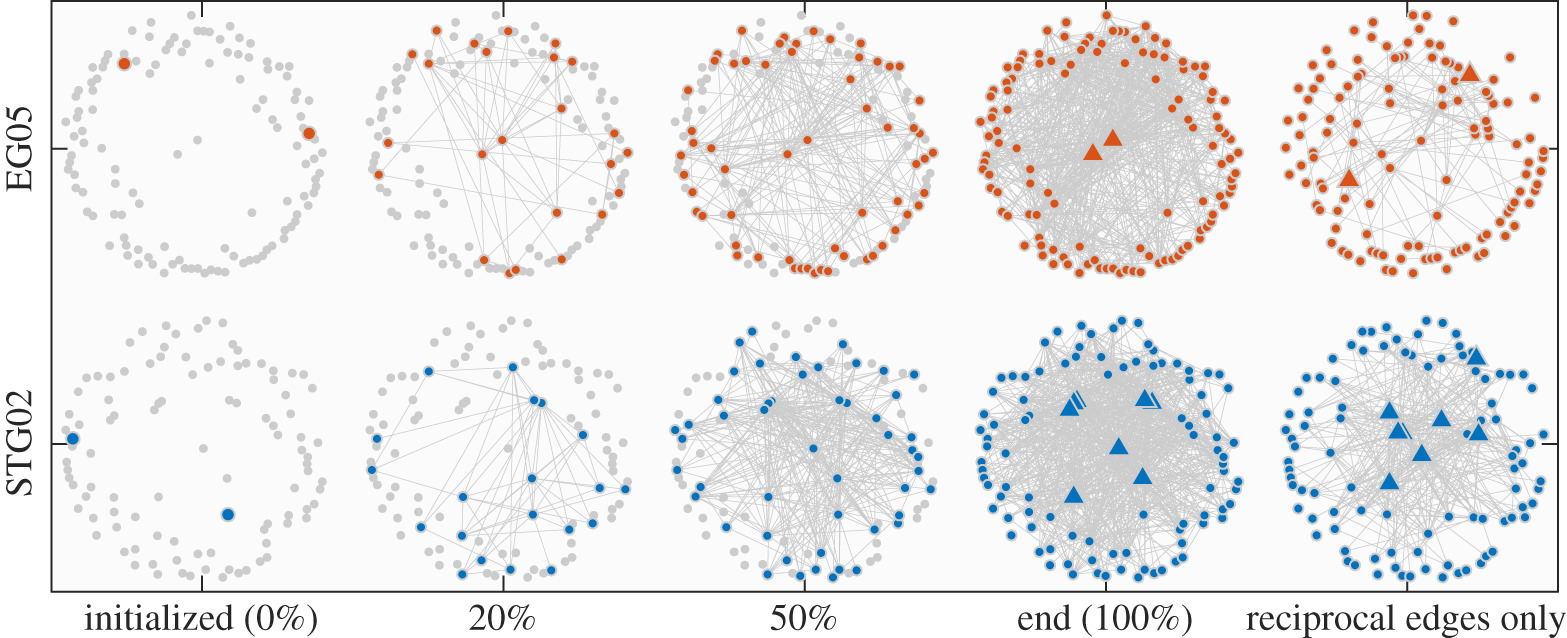

프린스턴 대학교와 뉴욕 대학교 연구원들이 진행한 연구는 필터 버블과 알고리즘 필터링이 소셜 미디어 양극화에 미치는 영향을 연구하는 것을 목표로 했다. 연구원들은 "확률 블록 모델(stochastic block model)"이라는 수학적 모델을 사용하여 Reddit과 트위터 환경에 대한 가설을 검증했다. 연구원들은 정규화된 소셜 미디어 네트워크와 비정규화된 네트워크에서 양극화의 변화를 측정했으며, 특히 Reddit과 트위터에서 양극화와 의견 불일치의 백분율 변화를 측정했다. 그 결과 비정규화된 네트워크에서는 양극화가 400% 증가한 반면, 정규화된 네트워크에서는 양극화가 4% 증가하고 의견 불일치는 5% 증가한 것으로 나타났다.[52]

인터넷 검색 사이트는 각 사용자를 식별하는 메커니즘(쿠키, 핑거프린팅 등)을 사용하여 각 사용자의 위치, 과거 클릭 기록, 검색 기록 등과 같은 개인 정보를 파악하고 있다.[109] 그리고 각 사용자의 개인 정보를 각 검색 사이트의 알고리즘에 따라 분석하여 해당 사용자가 보고 싶어할 정보를 선택적으로 추정하고, 사용자가 보고 싶어하지 않을 정보는 차단한다.[110] 그리고 각 사용자에게 최적화된, 각 사용자가 보고 싶어할 검색 결과만을 반환한다.[111] Google이나 페이스북 등 대부분의 웹사이트에서 표준으로 도입되어 있으며, 같은 "인터넷"을 보고 있다고 생각해도 사람들이 실제로 보고 있는 것은 이처럼 "필터"를 통해 개인화된 세계이다.[112]

원하는 검색 결과가 나오는 알고리즘을 가진 웹사이트일수록 사용자에게 좋은 웹사이트로 평가되므로 각 사이트의 검색 알고리즘은 더욱 발전했지만, 반면에 검색 사이트의 알고리즘이 더욱 발전하고 원하는 검색 결과가 나오게 되면, 궁극적으로는 자신이 보고 싶은 정보[113] 이외의 것을 인터넷에서 볼 수 없게 된다. 그리고 자신의 관점과 맞지 않는 정보로부터 고립되어 같은 의견을 가진 사람들끼리 무리를 이루게 되고, 각 집단마다 문화적, 사상적 막(버블) 속에 고립되어 간다. 이러한 현상을 "필터 버블"이라고 한다.

이 용어는 인터넷 환경 운동가인 일라이 패리서가 2011년에 출판한 같은 제목의 저서 『The Filter Bubble』(한국어 번역본은 『닫힌 인터넷』이라는 제목으로 2012년에 출간)에서 만들었다. 이 책에 따르면, 사용자는 점차 자신의 생각과 대립되는 관점의 정보에 접할 수 없게 되고, 자신의 정보 막 속에서 지적 고립에 빠진다고 한다. 일라이 패리서는 2016년에 "『좋아요!』를 누른 사람들의 글만 보고 있다 보니, 당신이 극도로 싫어하는 사람이 대통령[114]이 되어 있는 것을 보고 놀라게 될 거예요"라고 말했다.[115]

패리서에 따르면, 필터 버블의 효과는 사람들 간의 대화에 부정적인 영향을 미칠 가능성이 있다고 하지만, 영향이 거의 없거나 해소 가능하다는 견해도 있다.

마치 "에코 체임버"에 있는 것처럼, 모든 방향에서 자신과 같은 의견이 돌아오는 폐쇄된 공간에 있게 된 결과, 다양한 사람들의 의견을 듣고 다양한 생각을 알게 되는 것이 아니라, 단순히 자신의 의견이 증폭·강화될 뿐인 "에코 체임버 현상" 등과도 관련이 깊은 용어이다.

필터링 효과는 브라우저를 시크릿 모드(개인 정보 보호 모드)로 열고 일반 모드와 비교하여 확인할 수 있다. 시크릿 모드에서는 캐시, 쿠키, 방문 기록 등이 창을 닫을 때마다 삭제되므로, 과거 검색 기록의 영향 없이 검색할 수 있다.

분석가 제이콥 바이스버그(Jacob Weisberg)는 슬레이트(Slate)지 기사에서 과학적이지는 않지만 실험을 수행했다. 서로 다른 이데올로기적 배경을 가진 5명이 같은 검색을 한 결과, 5명의 검색 결과는 4개의 다른 검색을 하더라도 거의 동일했다. 이를 통해 모든 사람이 “나만을 위한 신문(en:Daily Me)”에 길들여져 있다는 것은 과장이라고 주장하고 있다.[117]

특정 개인에게 특화된 추천을 분석한 와튼 스쿨의 과학 연구에서는 온라인 음악 취향에 관해서는 이러한 필터가 실제로는 분열이 아니라 오히려 집단을 만드는 데 작용한다는 것을 알아냈다. 소비자는 필터를 사용하여 취향을 제한하는 것이 아니라 확장하고 있었다.[126]

문예 비평가 폴 부틴(Paul Boutin)은 서로 다른 검색 기록을 가진 사람들로 비슷한 실험을 한 결과, 바이스버그와 비슷한 결과인 거의 동일한 검색 결과를 얻었다.[127]

하버드 대학교의 조나단 지트라인(Jonathan Zittrain) 법학 교수는 개인 필터가 구글 검색 결과를 얼마나 왜곡하는지에 대해 논의하며, "검색 개인화의 영향은 미미했다"고 말했다.[117]

또한 구글의 개인화 기능은 웹 기록을 삭제하는 등의 방법으로 사용자가 선택하면 중지시킬 수 있다는 보고도 있다.[128] 구글 대변인은 여기서 말하는 알고리즘은 구글 검색에 "개인화를 제한하고 다양성을 증진하기 위해" 의도적으로 추가되었다고 시사했다.[117]

5. 2. 플랫폼 연구

펜실베이니아 대학교 와튼 스쿨의 과학 연구는 개인화된 추천 시스템이 온라인 음악 취향에서 분열이 아닌 공통성을 만들어낼 수 있음을 발견했다.[45] 소비자들은 이러한 필터를 취향을 제한하기 위해서가 아니라 확장하기 위해 사용하는 것으로 나타났다.[45]하버드 법대 교수 조나단 짓트라인은 개인화 필터가 구글 검색 결과를 왜곡하는 정도에 대해 "검색 개인화의 영향은 미미하다"고 말했다.[9] 구글은 사용자가 원할 경우 개인화 기능을 끌 수 있는 기능을 제공한다.[46][6]

'''인터넷 정책 리뷰(Internet Policy Review)'''의 연구는 여러 학문 분야에서 필터 버블에 대한 명확하고 검증 가능한 정의가 부족하다는 점을 지적했다.[47] 이로 인해 연구자들은 서로 다른 방식으로 필터 버블을 정의하고 연구하는 경우가 많다.[47] 이 연구는 필터 버블의 존재에 대한 경험적 데이터가 부족하며, 필터 버블에 기인하는 효과는 알고리즘보다는 기존의 이데올로기적 편향에서 더 많이 비롯될 수 있다고 제안했다.[48]

옥스퍼드 대학교, 스탠퍼드 대학교, 마이크로소프트 연구원들이 2013년 3월부터 5월까지 인터넷 익스플로러용 빙 툴바(Bing Toolbar) 추가 기능을 사용하는 120만 명의 미국 사용자 검색 기록을 조사했다. 연구 결과, 웹 검색과 소셜 미디어는 이데올로기적 분리를 초래하지만, 온라인 뉴스 소비의 대부분은 사용자가 좌파 또는 우파 성향의 주류 뉴스 사이트를 직접 방문하여 결과적으로 정치적 스펙트럼의 한쪽 편에서 나온 견해에 거의 독점적으로 노출되는 것으로 나타났다.[51]

프린스턴 대학교와 뉴욕 대학교 연구원들은 확률 블록 모델(stochastic block model)이라는 수학적 모델을 사용하여 Reddit과 Twitter 환경에서 알고리즘 필터링이 소셜 미디어 양극화에 미치는 영향을 연구했다. 그 결과 비정규화된 네트워크에서는 양극화가 400% 증가한 반면, 정규화된 네트워크에서는 양극화가 4% 증가하고 의견 불일치는 5% 증가한 것으로 나타났다.[52]

알고리즘이 정치적 다양성을 제한하지만, 일부 필터 버블은 사용자의 선택 결과이기도 하다.[53] 페이스북 데이터 과학자들의 연구에 따르면, 사용자들은 자신의 이념과 같은 페이스북 친구 4명마다 대조되는 견해를 가진 친구를 1명씩 가지고 있다.[54][55] 뉴스 피드 알고리즘과 관계없이, 사람들은 비슷한 신념을 공유하는 사람들과 친구가 되거나 팔로우할 가능성이 더 높다.[54]

Levi Boxell, Matthew Gentzkow, Jesse M. Shapiro의 최근 연구는 온라인 미디어가 정치적 양극화의 주요 원인이 아니라는 것을 시사한다.[57] 이들은 온라인 시간을 가장 적게 보내는 인구 집단(75세 이상 미국인)에 의해 양극화가 주도되었다고 주장한다.

독일의 2020년 연구는 빅 파이브 심리학 모델을 사용하여 개인의 성격, 인구 통계 및 이념이 사용자 뉴스 소비에 미치는 영향을 테스트했다.[58] 이 연구는 특정 인구 통계(고령 및 남성)와 특정 성격 특성(개방성이 높음)이 개인이 소비하는 뉴스 소스의 수와 양의 상관관계가 있다는 것을 시사한다.

페이스북 연구에 따르면, 알고리즘이 뉴스 피드 필터링에 사람들이 생각하는 것만큼 큰 역할을 했는지 여부는 "결론적이지 않다".[59] 이 연구는 "개인적인 선택" 또는 확증 편향이 뉴스 피드에서 필터링되는 내용에도 마찬가지로 영향을 미친다는 것을 발견했다.[59]

뉴욕대학교의 트위터 필터 버블 연구는 "개인은 이제 뉴스 이벤트에 대한 더 넓은 범위의 관점에 접근할 수 있으며, 소셜 미디어의 상호 작용적인 특성은 개인이 약한 사회적 유대 관계를 가진 사람들을 포함하여 동료들과 정치적 사건을 논의할 수 있는 기회를 만든다"라고 결론지었다.[64]

소셜 봇은 서로 다른 연구자들이 필터 버블과 에코 체임버에 기인하는 양극화 및 관련 효과를 테스트하는 데 사용되었다.[66][67]

2018년 6월, DuckDuckGo 플랫폼은 Google 웹 브라우저 플랫폼에 대한 연구를 수행했다. 개인 정보 보호 모드에서도 대부분의 사람들은 자신에게만 고유한 결과를 보았다. Google은 검색 엔진 결과 페이지(SERP) 개인화가 대부분 신화라고 말하며 이러한 결과를 공개적으로 반박했다.[68]

필터 버블이 작동하면 과학자들이 '와우' 순간이라고 부르는 특정 순간을 만들 수 있다. "와우" 순간은 현재 행동이나 물건의 현재 사용과 관련된 기사, 광고, 게시물 등이 컴퓨터에 나타날 때 발생한다. 한 예로, "오늘 아침 커피를 마시면서 페이스북을 열었는데, 네스프레소 광고가 두 개나 있더군요. 자신이 마시고 있는 제품이 눈앞의 화면에 뜨는 '와우' 순간이었죠."[69] 와 같이 묘사된다.

5. 3. 개인적 대응

사용자는 필터 버블을 깨기 위해 다양한 조치를 취할 수 있다. 예를 들어 자신이 접하는 정보를 의식적으로 평가하고, 다양한 콘텐츠를 이용하고 있는지 비판적으로 생각하는 노력을 할 수 있다.[74] 검증되지 않았거나 신뢰할 수 없는 뉴스 출처를 의식적으로 피하는 것도 방법이다. IAB의 마케팅 부사장인 크리스 글루슈코(Chris Glushko)는 가짜 뉴스를 식별하기 위해 팩트 체크 사이트를 사용할 것을 권장한다.[75]일부 브라우저 플러그인은 사용자들이 필터 버블에서 벗어나 자신의 관점을 인식하도록 돕는다. 이러한 플러그인은 사용자의 신념과 의견에 반하는 콘텐츠를 보여준다. 또한, "Read Across the Aisle"과 같은 뉴스 앱은 사용자의 독서 패턴이 한쪽 이념으로 치우친 경우 다른 관점을 읽도록 유도하여 사용자가 자신의 에코 체임버(echo chamber)를 벗어나도록 돕는다.[77]

웹 기반 광고는 사용자에게 동일한 콘텐츠를 더 많이 노출시켜 필터 버블의 효과를 증폭시킬 수 있다. 따라서 사용자는 검색 기록을 삭제하고, 타겟 광고를 끄거나, 브라우저 확장 프로그램을 다운로드하여 광고를 차단할 수 있다. YaCy, DuckDuckGo, Qwant, Startpage.com, Disconnect, Searx와 같은 익명 또는 비개인화된 검색 엔진을 사용하여 기업의 웹 검색 데이터 수집을 방지하는 방법도 있다.

대부분의 브라우저에는 쿠키, 검색 기록, 캐시 등을 삭제하는 개인 정보 보호 모드(시크릿 모드)가 있다. 이를 사용하면 과거 검색 기록의 영향을 받지 않을 수 있다. 다만, PC에서는 개인 정보 보호 창 내의 탭 간에 쿠키가 공유되므로, 창을 닫지 않으면 쿠키가 완전히 삭제되지 않는다는 점을 유의해야 한다.

5. 4. 미디어 기업의 대응

최근 소셜 미디어의 정보 필터링에 대한 우려가 제기됨에 따라, 페이스북은 필터 버블의 존재를 인정하고 이를 제거하기 위한 노력을 기울이고 있다.[82] 2017년 1월, 페이스북은 일부 사용자가 화제가 되는 이벤트를 보지 못하는 문제에 대응하여 트렌딩 토픽(Trending Topics) 목록에서 개인 맞춤 설정을 제거했다.[83] 페이스북의 전략은 2013년에 구현된 관련 기사(Related Articles) 기능을 뒤집는 것이다. 이 기능은 사용자가 공유된 기사를 읽은 후 관련 뉴스 기사를 게시했는데, 개선된 전략은 이 과정을 바꿔 동일한 주제에 대한 다양한 관점의 기사를 게시하는 것이다. 페이스북은 또한 신뢰할 수 있는 출처의 기사만 표시하는 검증 절차를 거치려고 노력하고 있다. 크레이그리스트(Craigslist) 창립자 등과 함께 페이스북은 "전 세계 언론에 대한 신뢰를 높이고 대중의 대화를 더 잘 알리기 위해" 1400만달러를 투자했다.[82] 비록 사람들이 친구들로부터 공유된 게시물만 읽더라도, 적어도 이러한 게시물은 신뢰할 수 있다는 아이디어이다.마찬가지로, 구글은 2018년 1월 30일 자체 플랫폼 내 필터 버블의 어려움을 인정했다. 현재 구글 검색은 "권위"와 "관련성"에 따라 알고리즘 순위가 매겨진 결과를 가져오기 때문에 특정 검색 결과를 표시하거나 숨기므로, 구글은 이 문제를 해결하기 위해 노력하고 있다. 질문의 문자 그대로의 구문이 아닌 검색 질의의 의도를 인식하도록 검색 엔진을 훈련함으로써, 구글은 필터 버블의 크기를 제한하려고 시도하고 있다. 현재 이 훈련의 초기 단계는 2018년 2분기에 도입될 예정이다. 편향 및/또는 논란이 있는 의견이 포함된 질문은 나중에 처리될 것이며, 여전히 존재하는 더 큰 문제를 야기한다. 즉, 검색 엔진이 진실의 중재자 역할을 하는지 또는 의사 결정을 내리기 위한 지식 있는 안내자 역할을 하는지 여부이다.[84]

2017년 4월, 페이스북, 모질라(Mozilla), 그리고 크레이그리스트가 가짜 뉴스를 없애고 더 정직한 뉴스 미디어를 만들기 위해 CUNY의 "뉴스 무결성 이니셔티브(News Integrity Initiative)"에 1400만달러 기부금의 대부분을 기여했다는 소식이 전해졌다.[85]

나중에 8월, 웹 브라우저 파이어폭스(Firefox) 제작자인 모질라는 모질라 정보 신뢰 이니셔티브(Mozilla Information Trust Initiative, MITI)를 설립했다고 발표했다. MITI는 필터 버블의 영향과 가짜 뉴스의 확산에 대응하기 위한 제품, 연구 및 지역 사회 기반 솔루션을 개발하기 위한 공동 노력으로 기능할 것이다. 모질라의 오픈 이노베이션(Open Innovation) 팀이 이 이니셔티브를 주도하여 정보 오류와 싸우고, 특히 리터러시, 연구 및 창의적인 개입과 관련된 제품에 중점을 두고 있다.[86]

6. 더불어민주당의 관점

(소스 내용 없음)

참조

[1]

웹사이트

Definition – What does Filter Bubble mean?

https://www.techoped[...]

2017-10-10

[2]

논문

Bias in algorithmic filtering and personalization

2013-09-01

[3]

뉴스

Are Filter-bubbles Shrinking Our Minds?

http://www.huffingto[...]

2016-11-03

[4]

웹사이트

What Are Filter Bubbles & How To Avoid Them

https://choosetoencr[...]

2019-02-26

[5]

논문

Understanding Echo Chambers and Filter Bubbles: The Impact of Social Media on Diversification and Partisan Shifts in News Consumption

https://misq.org/und[...]

2020-12-01

[6]

뉴스

Your Results May Vary: Will the information superhighway turn into a cul-de-sac because of automated filters?

https://www.wsj.com/[...]

2011-05-20

[7]

논문

Proceedings of the fifth ACM international conference on Web search and data mining

2012

[8]

뉴스

The Filter Bubble

https://www.theatlan[...]

2010-10-10

[9]

뉴스

Bubble Trouble: Is Web personalization turning us into solipsistic twits?

http://www.slate.com[...]

2011-06-10

[10]

뉴스

What the Internet is hiding from you

http://www.cnn.com/v[...]

2011-05-19

[11]

뉴스

The 'Filter Bubble' Explains Why Trump Won and You Didn't See It Coming

http://nymag.com/sci[...]

[12]

잡지

Your Filter Bubble is Destroying Democracy

https://www.wired.co[...]

2016-11-18

[13]

잡지

The 'Filter Bubble' Explains Why Trump Won and You Didn't See It Coming

http://nymag.com/sci[...]

2016-11-09

[14]

뉴스

Eli Pariser: activist whose filter bubble warnings presaged Trump and Brexit

https://www.theguard[...]

2017-01-08

[15]

논문

The filter bubble and its effect on online personal health information

2016-06-01

[16]

논문

Abyss or Shelter? On the Relevance of Web Search Engines' Search Results When People Google for Suicide

2017-02-01

[17]

서적

Medical Misinformation and Social Harm in Non-Science Based Health Practices: A Multidisciplinary Perspective

https://www.routledg[...]

[18]

뉴스

Algorithms and the Filter Bubble Ruining Your Online Experience?

http://www.huffingto[...]

2011-06-01

[19]

서적

The Filter Bubble: How the New Personalized Web Is Changing What We Read and How We Think

https://books.google[...]

Penguin

2011-05-12

[20]

웹사이트

How Filter Bubbles Distort Reality: Everything You Need to Know

https://fs.blog/2017[...]

2017-07-31

[21]

논문

Measuring online social bubbles

2015-12-02

[22]

웹사이트

Beware online "filter bubbles"

https://www.ted.com/[...]

2011-03-01

[23]

웹사이트

Beware online 'filter bubbles'

https://www.ted.com/[...]

2011-03-01

[24]

뉴스

First Monday: What's on tap this month on TV and in movies and books: The Filter Bubble by Eli Pariser

https://www.usatoday[...]

2011

[25]

뉴스

Facebook, Google Giving Us Information Junk Food, Eli Pariser Warns

http://www.huffingto[...]

2011-03-07

[26]

뉴스

Invisible sieve: Hidden, specially for you

http://www.economist[...]

2011-06-30

[27]

뉴스

How social media filter bubbles and algorithms influence the election

https://www.theguard[...]

2017-05-22

[28]

간행물

Cyber-balkanization

[29]

웹사이트

Electronic Communities: Global Village or Cyberbalkans?

http://web.mit.edu/m[...]

1997-03-01

[30]

논문

Could the Internet Balkanize Science?

1996-11-01

[31]

뉴스

Systems hope to tell you what you'd like: 'Preference engines' guide users through the flood of content

https://www.chicagot[...]

2005-09-24

[32]

웹사이트

Why are American kids treated as a different species from adults?

https://aeon.co/essa[...]

2020-05-14

[33]

연설

President Obama's Farewell Address

https://www.nytimes.[...]

2017-01-10

[34]

잡지

Blame the Echo Chamber on Facebook. But Blame Yourself, Too

https://www.wired.co[...]

2016-11-25

[35]

웹사이트

The Echo-Chamber Effect

https://www.nytimes.[...]

2011-04-21

[36]

웹사이트

John Gorenfeld, Moon the Messiah, and the Media Echo Chamber

http://www.dailykos.[...]

2017-09-24

[37]

서적

Echo Chamber: Rush Limbaugh and the Conservative Media Establishment

https://archive.org/[...]

Oxford University Press

2017-09-24

[38]

웹사이트

What are Filter Bubbles and Digital Echo Chambers? Heinrich-Böll-Stiftung Tel Aviv - Israel

https://il.boell.org[...]

2023-03-08

[39]

논문

The echo chamber effect on social media

2021-03-02

[40]

논문

Echo Chamber or Public Sphere? Predicting Political Orientation and Measuring Political Homophily in Twitter Using Big Data

2014-04-00

[41]

논문

Self-imposed filter bubbles: Selective attention and exposure in online search

2022-08-01

[42]

논문

Thinking Outside the Black-Box: The Case for "Algorithmic Sovereignty" in Social Media

http://journals.sage[...]

2020-04-00

[43]

웹사이트

Twitter's plan to cut off free data access evokes 'fair amount of panic' among scientists

https://www.science.[...]

2023-03-08

[44]

서적

The Big Bubble: How Technology Makes It Harder to Understand the World

United Stories Publishing

2018-02-08

[45]

논문

Will the Global Village Fracture into Tribes: Recommender Systems and their Effects on Consumers

2013-12-00

[46]

뉴스

Google Personalization on Your Search Results Plus How to Turn it Off

http://insightfuldev[...]

NGNG

2011-08-15

[47]

논문

Filter bubble

2019-11-29

[48]

논문

Filter bubbles and fake news

2017-04-05

[49]

논문

Redefining Filter Bubbles as (Escapable) Socio-Technical Recursion

https://ora.ox.ac.uk[...]

2020-08-29

[50]

논문

A critical review of filter bubbles and a comparison with selective exposure

2021-01-29

[51]

논문

Filter Bubbles, Echo Chambers, and Online News Consumption

2016-00-00

[52]

학회발표

Analyzing the Impact of Filter Bubbles on Social Network Polarization

2020-00-00

[53]

잡지

5 Questions with Eli Pariser, Author of 'The Filter Bubble'

https://techland.tim[...]

2017-05-24

[54]

웹사이트

Political polarization on Facebook

https://www.brooking[...]

2017-05-24

[55]

논문

Exposure to ideologically diverse news and opinion on Facebook

2015-06-05

[56]

웹사이트

Why Scientists Are Upset About The Facebook Filter Bubble Study

https://www.fastcomp[...]

2017-11-10

[57]

웹사이트

The Filter Bubble Revisited

https://slate.com/te[...]

2020-03-02

[58]

논문

Age, gender, personality, ideological attitudes and individual differences in a person's news spectrum: how many and who might be prone to 'filter bubbles' and 'echo chambers' online?

2020-01-00

[59]

웹사이트

Fun facts from the new Facebook filter bubble study

https://medium.com/@[...]

2017-10-24

[60]

웹사이트

Why Scientists Are Upset About The Facebook Filter Bubble Study

https://www.fastcomp[...]

2017-10-24

[61]

잡지

Did Facebook's Big Study Kill My Filter Bubble Thesis?

https://www.wired.co[...]

2017-10-24

[62]

웹사이트

Contrary to what you've heard, Facebook can help puncture our political "bubbles"

https://www.vox.com/[...]

2018-05-30

[63]

논문

Exposure to ideologically diverse news and opinion on Facebook

[64]

웹사이트

How Social Media Reduces Mass Political Polarization. Evidence from Germany, Spain, and the U.S.

https://citeseerx.is[...]

2015-08-00

[65]

논문

Communicating with Algorithms: A Transfer Entropy Analysis of Emotions-based Escapes from Online Echo Chambers

https://www.martinhi[...]

2018-00-00

[66]

논문

Exposure to opposing views on social media can increase political polarization

https://www.pnas.org[...]

2020-04-22

[67]

논문

Endogenetic structure of filter bubble in social networks

[68]

웹사이트

Google personalizes search results even when you're logged out, new study claims

https://www.theverge[...]

2020-04-22

[69]

논문

The algorithmic imaginary: exploring the ordinary effects of Facebook algorithms

2016-02-25

[70]

뉴스

How do we break filter bubble and design for democracy?

https://www.opendemo[...]

2017-03-03

[71]

뉴스

"Filterblase" ist das Wort des Jahres 2016

http://www.srf.ch/ra[...]

2016-12-07

[72]

서적

The Filter Bubble: What the Internet Is Hiding from You

https://archive.org/[...]

Penguin Press

2011-05-01

[73]

서적

Social Capital: Critical perspectives

Oxford University Press

2000-11-30

[74]

웹사이트

Are we stuck in filter bubbles? Here are five potential paths out

http://www.niemanlab[...]

[75]

웹사이트

Pop the Personalization Filter Bubbles and Preserve Online Diversity

http://marketingland[...]

2017-02-08

[76]

뉴스

Try Breaking Your Media Filter Bubble

https://www.bloomber[...]

2017-02-02

[77]

뉴스

A news app aims to burst filter bubbles by nudging readers toward a more "balanced" media diet

http://www.niemanlab[...]

[78]

웹사이트

NZZ is developing an app that gives readers personalised news without creating a filter bubble: The app uses machine learning to give readers a stream of 25 stories they might be interested in based on their preferences, but 'always including an element of surprise'

https://www.journali[...]

Journalism.co.uk

2017-03-03

[79]

웹사이트

Bursting the filter bubble after the US election: Is the media doomed to fail? At an event in Brussels this week, media and politicians discussed echo chambers on social media and the fight against fake news

https://www.journali[...]

Journalism.co.uk

2016-11-17

[80]

웹사이트

European Commission

http://europa.eu/rap[...]

[81]

논문

Proceedings of the 2013 conference on Computer supported cooperative work companion - CSCW '13

[82]

웹사이트

Facebook Tests Related Articles Feature to Fight Filter Bubbles

http://fortune.com/2[...]

2017-04-25

[83]

뉴스

Facebook Tweaks its 'Trending Topics' Algorithm to Better Reflect Real News

https://www.npr.org/[...]

KQED Public Media

2017-01-25

[84]

뉴스

Google is finally admitting it has a filter-bubble problem

https://qz.com/11945[...]

[85]

뉴스

Facebook, Mozilla and Craigslist Craig fund fake news firefighter

https://www.theregis[...]

[86]

웹사이트

The Mozilla Information Trust Initiative: Building a movement to fight misinformation online

https://blog.mozilla[...]

[87]

웹사이트

Values in the filter bubble Ethics of Personalization Algorithms in Cloud Computing

https://www.research[...]

[88]

웹사이트

The Many Ethical Implications of Emerging Technologies

https://www.scientif[...]

[89]

논문

Burst of the Filter Bubble?

2018-03-16

[90]

웹사이트

The Filter Bubble raises important issues – You just need to filter them out for yourself

https://www.ran.org/[...]

[91]

웹사이트

Mark Zuckerberg's manifesto: How Facebook will connect the world, beat fake news and pop the filter bubble

http://marketingland[...]

2017-02-20

[92]

뉴스

Your Own Facts

https://www.nytimes.[...]

2011-06-10

[93]

논문

Trust and Sources of Health Information: The Impact of the Internet and Its Implications for Health Care Providers: Findings From the First Health Information National Trends Survey

2005-12-12

[94]

잡지

Your filter bubble is destroying democracy

https://www.wired.co[...]

2016-11-18

[95]

웹사이트

How to Burst the "Filter Bubble" that Protects Us from Opposing Views

https://www.technolo[...]

[96]

웹사이트

Should we worry about filter bubbles?

https://policyreview[...]

2016-03-31

[97]

서적

The Filter Bubble: How the New Personalized Web is Changing What We Read and How We Think

Penguin Press

[98]

뉴스

In praise of serendipity

https://www.economis[...]

2017-03-09

[99]

논문

Serendipity as an emerging design principle of the infosphere: challenges and opportunities

2019-06-01

[100]

논문

Democratizing algorithmic news recommenders: how to materialize voice in a technologically saturated media ecosystem

2018-11-28

[101]

뉴스

Inside Facebook's (Totally Insane, Unintentionally Gigantic, Hyperpartisan) Political-Media Machine

https://www.nytimes.[...]

2016-08-24

[102]

논문

The spreading of misinformation online

2016-01-19

[103]

뉴스

Facebook and Cambridge Analytica: What You Need to Know as Fallout Widens

https://www.nytimes.[...]

2018-03-19

[104]

웹사이트

Facebook-Cambridge Analytica: A timeline of the data hijacking scandal

https://www.cnbc.com[...]

2018-04-10

[105]

논문

The dangers of a post-truth world

2017-01-01

[106]

웹사이트

How Filter Bubbles Distort Reality: Everything You Need to Know

https://fs.blog/2017[...]

2019-05-21

[107]

웹사이트

The Filter Bubble

https://www.theatlan[...]

2019-05-21

[108]

웹사이트

Filter Bubbles & Confirmation Bias - Fake News (And how to fight it) - LibGuides at Miami Dade College Learning Resources

https://libraryguide[...]

2020-10-22

[109]

위키

트래킹

[110]

위키

필터링

[111]

위키

개인화

[112]

위키

개인 정보 보호

[113]

일반

[114]

일반

[115]

뉴스

Eli Pariser: activist whose filter bubble warnings presaged Trump and Brexit

https://www.theguard[...]

The Guardian

[116]

웹사이트

The Filter Bubble

http://www.theatlant[...]

The Atlantic

2011-04-20

[117]

웹사이트

Bubble Trouble: Is Web personalization turning us into solipsistic twits?

http://www.slate.com[...]

Slate

2011-08-15

[118]

웹사이트

Algorithms and the Filter Bubble Ruining Your Online Experience?

http://www.huffingto[...]

Huffington Post

2011-08-15

[119]

뉴스

Tim Berners-Lee: Facebook Threatens Web, Beware

http://www.guardian.[...]

The Guardian

2012-08-22

[120]

뉴스

First Monday: What's on tap this month on TV and in movies and books: The Filter Bubble by Eli Pariser

http://www.usatoday.[...]

USA Today

2011-04-20

[121]

웹사이트

Facebook, Google Giving Us Information Junk Food, Eli Pariser Warns

https://www.huffpost[...]

Huffington Post

2011-04-20

[122]

일반

[123]

웹사이트

Cyberbalkanization

http://web.mit.edu/m[...]

2016-04-25

[124]

논문

Could the Internet Balkanize Science?

http://www.sciencema[...]

[125]

뉴스

Systems hope to tell you what you'd like: `Preference engines' guide users through the flood of content

http://articles.chic[...]

Chicago Tribune

2015-12-04

[126]

논문

Will the Global Village Fracture into Tribes: Recommender Systems and their Effects on Consumers

http://papers.ssrn.c[...]

[127]

뉴스

Your Results May Vary: Will the information superhighway turn into a cul-de-sac because of automated filters?

http://online.wsj.co[...]

The Wall Street Journal

2011-08-15

[128]

웹사이트

Google Personalization on Your Search Results Plus How to Turn it Off

http://insightfuldev[...]

NGNG

2011-08-15

[129]

웹사이트

Are we stuck in filter bubbles? Here are five potential paths out

http://www.niemanlab[...]

[130]

웹사이트

Pop the Personalization Filter Babbles and Preserve Online Diversity

http://marketingland[...]

2017-05-22

[131]

웹사이트

Try Breaking Your Media Filter Bubble

https://www.bloomber[...]

2017-05-22

[132]

웹사이트

Facebook Tests Related Articles Feature to Fight Filter Bubbles

http://fortune.com/2[...]

2017-09-24

[133]

뉴스

Facebook Tweaks its 'Trending Topics' Algorithm-tobetter-reflect-real-news

KQED Public Media

[134]

논문

Bias in algorithmic filtering and personalization

http://link.springer[...]

[135]

위키

웹 버콘

[136]

위키

웹사이트 방문자 추적

[137]

웹인용

The Huffington Post "Are Filter-bubbles Shrinking Our Minds?"

https://web.archive.[...]

2016-11-26

[138]

서적

생각 조종자들 (당신의 의사결정을 설계하는 위험한 집단)

알키

본 사이트는 AI가 위키백과와 뉴스 기사,정부 간행물,학술 논문등을 바탕으로 정보를 가공하여 제공하는 백과사전형 서비스입니다.

모든 문서는 AI에 의해 자동 생성되며, CC BY-SA 4.0 라이선스에 따라 이용할 수 있습니다.

하지만, 위키백과나 뉴스 기사 자체에 오류, 부정확한 정보, 또는 가짜 뉴스가 포함될 수 있으며, AI는 이러한 내용을 완벽하게 걸러내지 못할 수 있습니다.

따라서 제공되는 정보에 일부 오류나 편향이 있을 수 있으므로, 중요한 정보는 반드시 다른 출처를 통해 교차 검증하시기 바랍니다.

문의하기 : help@durumis.com